本条内容由 gpt-5-mini 回复

很可能由下面几类原因导致:本地/在线模型切换或首次下载、CUDA 未启用或驱动不兼容、并发设置或“发送完整字幕”导致翻译队列变长、配音/翻译被在线接口限流,或开启了会大幅增加耗时的选项(如“保留原始背景音”)。请按下面步骤逐项排查并修复:

先看日志(最关键)

- 路径:软件根目录/videotrans/logs/ ,打开最近日期的 .log 文件。

- 留意关键字:download、timeout、403、rate limit、cudaError、模型文件路径 或 “waiting for model”等。

- 如有明显错误(403、超时、cudaError**等),把该日志片段一起贴出来。

快速检查并临时调速的最小配置(用于排查瓶颈)

- 语音识别渠道:设为 faster-whisper(本地)(若无本地模型,会触发下载,首次使用会很慢);或临时切回在线识别测试速度。

- 翻译渠道:设置为一个稳定的在线渠道(如 Google)做对比测试。

- 配音渠道:Edge-TTS(免费)可用,但如遇限流请按下面调整。

- 高级选项(菜单 -> 工具/选项 -> 高级选项):

a. 将“同时翻译的字幕数”设为 1;

b. 取消勾选“发送完整字幕”(若存在该项);

c. 在“配音调整”里将“同时配音字幕数”设为 1,“配音后暂停时间/秒”设为 5。 - 关闭“保留原始背景音”(会显著加时),如果在做测试可暂时不嵌入/不烧录硬字幕。

检查 GPU / CUDA 加速

- 若有 NVIDIA,请确认软件中已勾选“CUDA加速”,并用 nvidia-smi 或任务管理器观察 GPU 占用。

- 若看到 cudaErrorNoKernelImageForDevice 或 GPU 无法使用:更新显卡驱动或 CUDA 到兼容版本(FAQ 推荐 CUDA 12.x),或暂时取消勾选“CUDA加速”回退 CPU 模式做对比。

是否是“首次下载本地模型”导致挂起

- 新版本可能改用更大更慢的本地模型,首次运行会自动下载且耗时很长。检查日志是否有下载进度/失败信息,或在软件设置里手动下载模型文件。

网络或 API 限流问题

- 如果使用在线翻译或 Edge-TTS,网络不稳或被限流会导致长时间卡住。日志中常见 403/429/timeout。

- 解决:降低并发(上面第2步已设置),延长配音暂停时间,或更换为其他在线渠道/本地 TTS 测试。

- 排查流程(按序执行,节省时间)

1) 打开最新日志,找错误关键词并截取关键段落。

2) 将“同时翻译字幕数”设为 1,取消“发送完整字幕”,关闭“保留原始背景音”,配音并发设为 1,配音暂停 5 秒。

3) 启用 CUDA(若有 GPU),运行一个短视频测试(1~2 分钟)观察进度曲线与日志输出。

4) 如仍卡在 70-80%,切换到另一个识别/翻译/配音渠道分别测试以定位是哪一步变慢(ASR/翻译/配音/合成)。 如果自行排查无果,请提供以下信息便于进一步分析:

- videotrans/logs/ 下最新的 .log 文件(或其中包含错误的片段)。

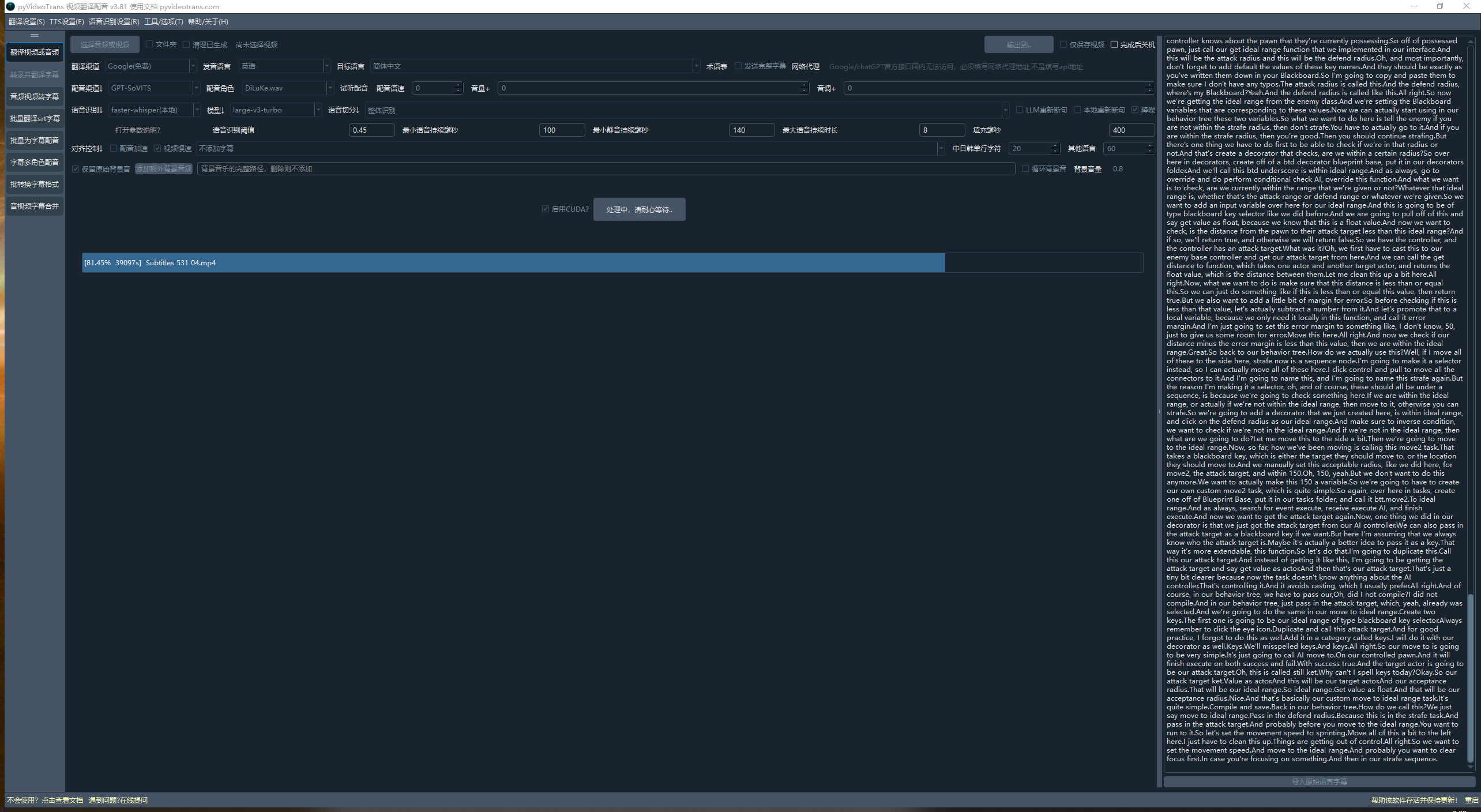

- 当前菜单中:语音识别渠道、翻译渠道、配音渠道 的完整设置截图或文本。

- 是否勾选“CUDA加速”,是否为首次使用本地模型(是否在最近下载模型)。

- 大致视频时长与此前能在1小时内完成的旧版本对比说明。

如果按照上述步骤仍无法恢复速度,请将最新日志文件和当前设置贴上,我会基于日志给出更具体的修复方案。