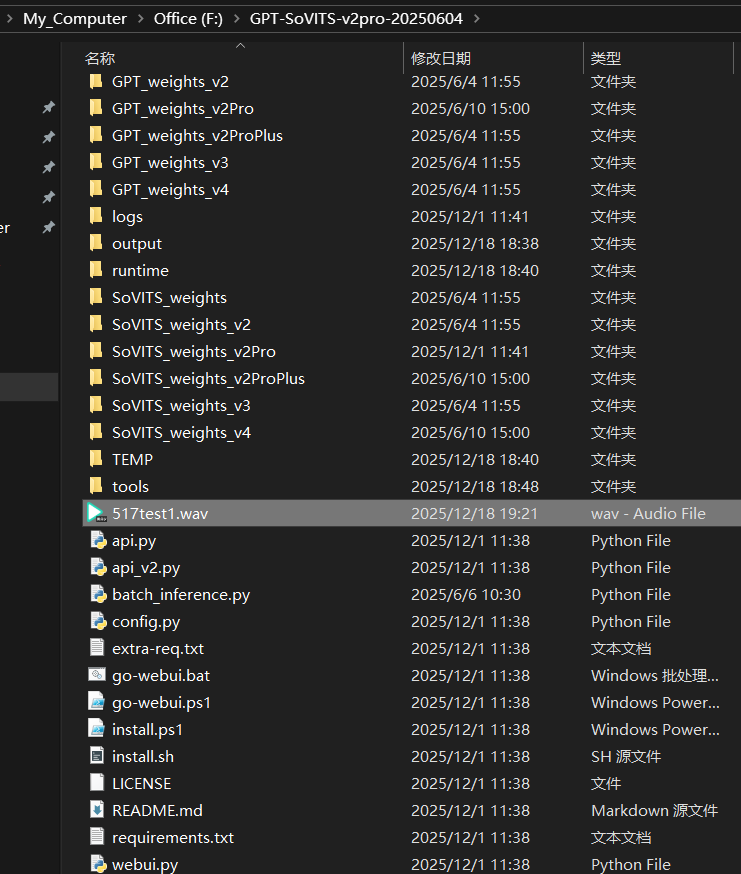

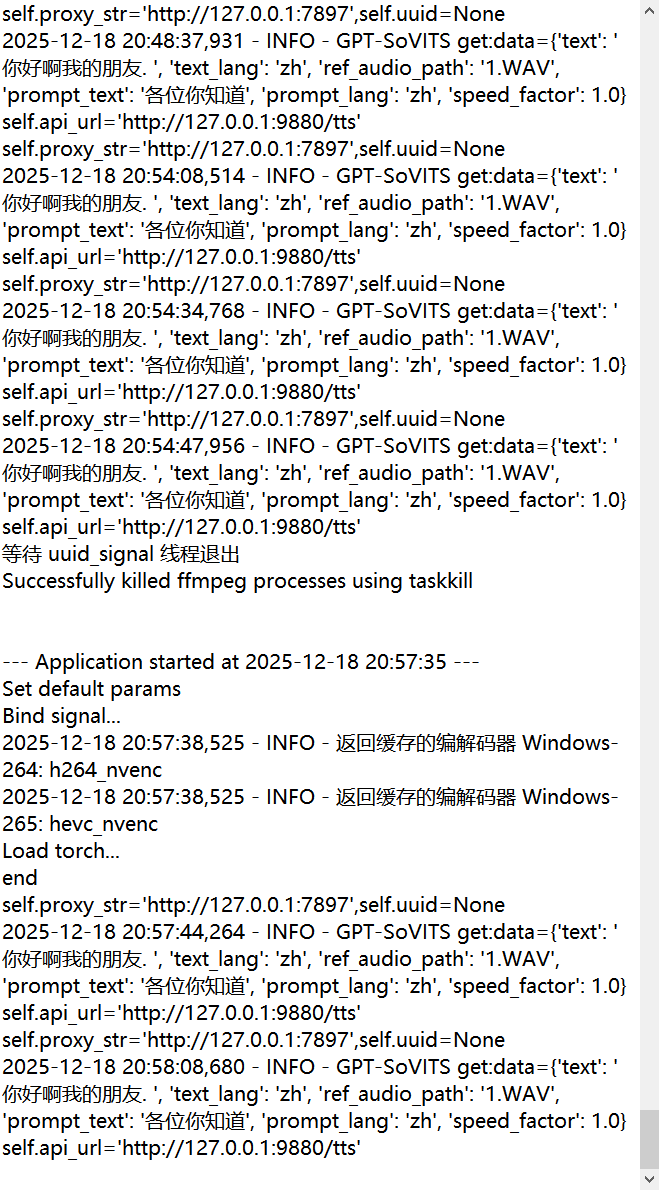

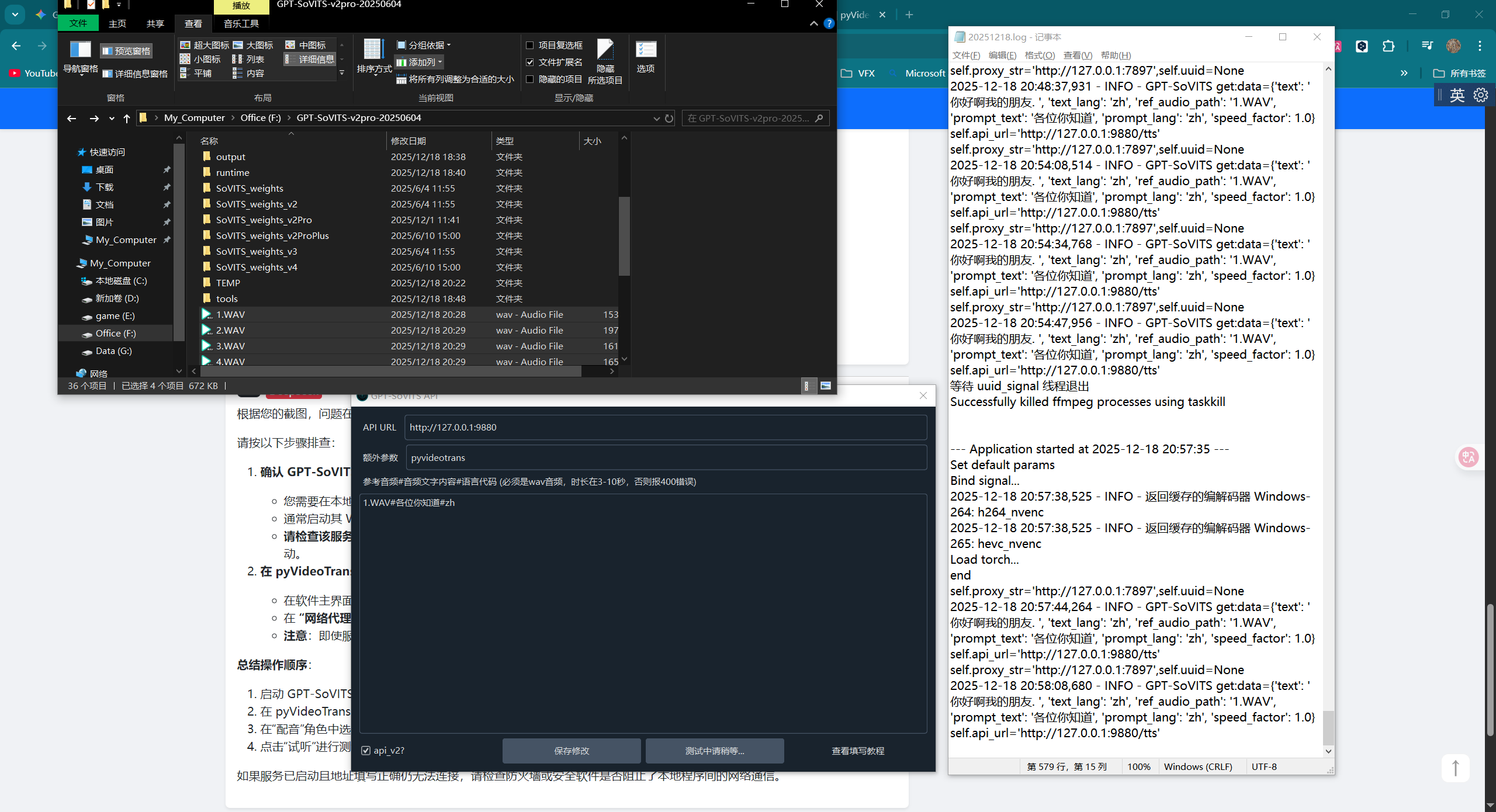

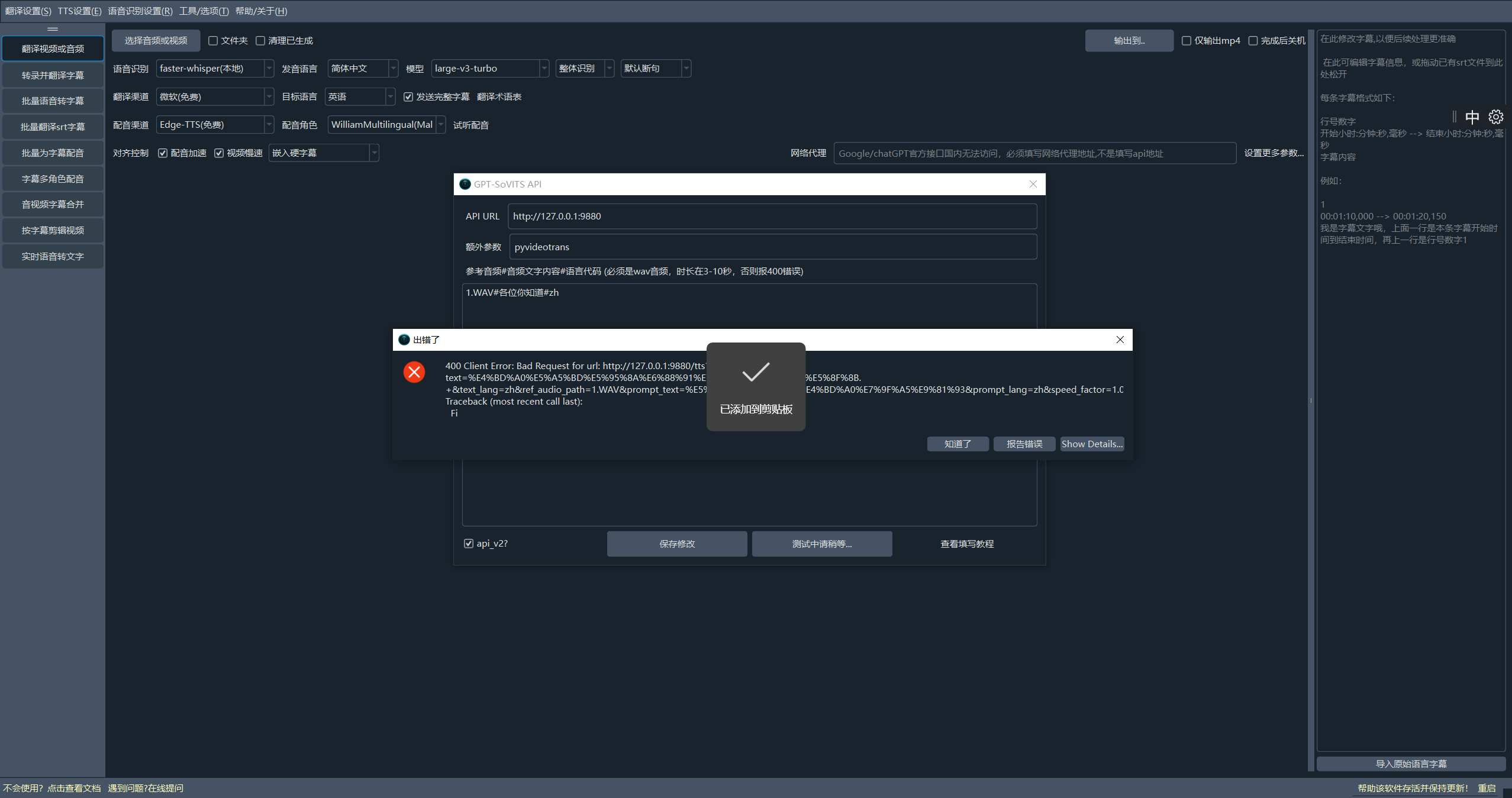

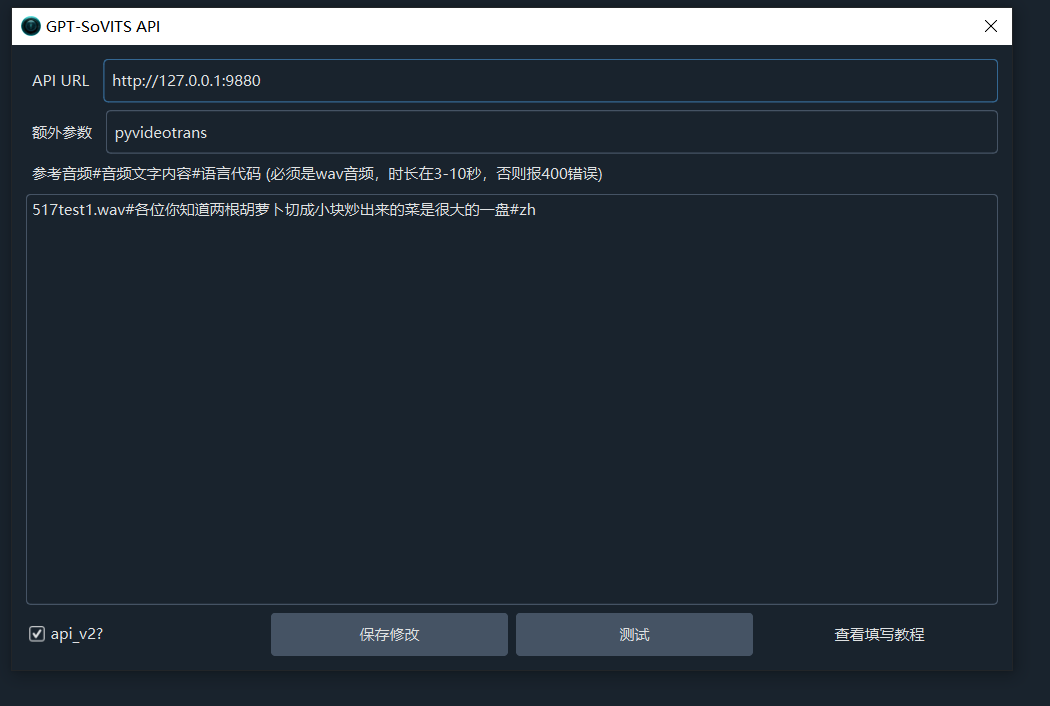

GPT-SoVITS参考音频文件

#2121 GPT-SoVITS参考音频文件

172.104*

Posted at: 2 months ago 👁243

17 Replies

Post Your Reply

Open source and free maintenance is not easy. If this project is helpful to you, please consider making a small donation to help the project continue to maintain and update.