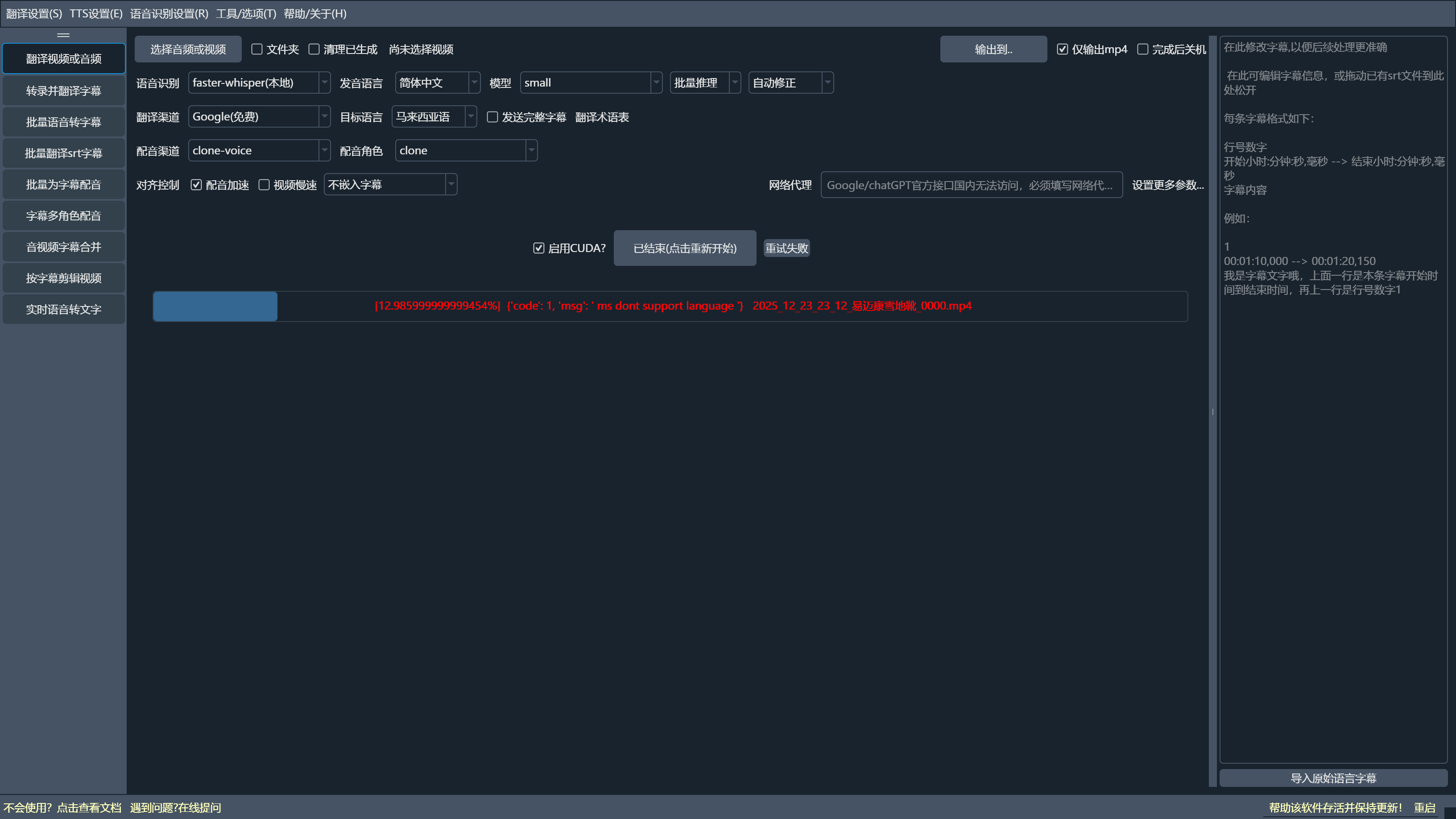

我的电脑配置

I5-12600kf

3070 8G

16G内存

开启了CUDA

用的large-V3跑还是很慢 10分钟不到百分之1是为什么呢?我哪里没设置好吗

#2260 我的电脑配置I5-12600kf3070 8G16G内存开启了CUDA用的large-V3跑还是很慢 10分钟不到百分之1是为什么呢?我哪里没设置好吗

154.26*

Posted at: 2 months ago 👁171

11 Replies

Post Your Reply

Open source and free maintenance is not easy. If this project is helpful to you, please consider making a small donation to help the project continue to maintain and update.