您遇到的问题是语音识别中的常见现象:模型将非人声(如狗叫)也误识别为文字并混入了字幕。这是因为语音识别模型本质上是一个“声音转文字”的模型,当它遇到有规律的、类似语音的声响时,可能会产生“幻觉”,输出它认为最可能的文字。

要解决这个问题,请按以下步骤操作,核心思路是 “优化输入音频,帮助模型更好地区分人声与非人声”:

第一步:预处理音频(最关键)

在识别之前,对音频进行降噪处理,减少狗叫声等背景音的干扰。

- 在软件主界面,点击 菜单栏 -> 工具 -> 选项 -> 高级选项。

- 在“通用设置”区域,找到并勾选

降噪 选项。 - 关闭高级选项窗口。

第二步:调整识别参数(VAD)

通过调整语音活动检测(VAD)参数,让模型更精确地只切分出人声片段。

- 再次打开 高级选项。

- 找到 “Faster/OpenAI/Whisper 语音识别微调” 区域(FunASR 也使用这些VAD参数)。

调整以下两个关键参数:

语音阈值:调高此值(例如从默认的 0.45 调到 0.5 或 0.6)。这会让模型更“保守”,只把能量较高、更像人声的部分切出来,过滤掉像狗叫这样的声音。静音分割持续毫秒:可以适当调小(例如从 140 调到 100)。这会让模型在检测到较短静音时就进行切分,防止将人声和后面的狗叫连成一个长片段。

- 关闭高级选项窗口。

第三步:进行识别并手动修正

- 使用上述设置后,重新对您的视频进行识别(务必勾选主界面第1行的“清理已生成”,否则会使用旧缓存)。

- 识别完成后,软件会弹出“字幕编辑”窗口。

- 此时,狗叫声被误识别的文字应该会大幅减少。您需要手动检查并删除那些明显是狗叫产生的无意义文字行(例如“汪”、“嗷”或奇怪的拼音组合)。

- 编辑完成后,再继续后续的翻译和配音流程。

备选方案(如果上述方法效果不佳)

如果狗叫声非常突出且持续,与小孩声音高度重叠,上述方法可能仍无法完全滤除。此时,更彻底的解决方案是:

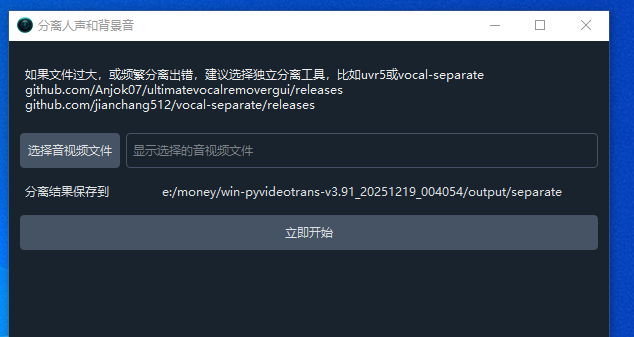

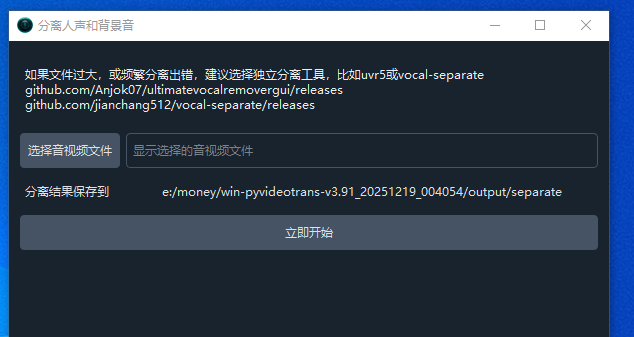

- 使用“人声分离”功能:在识别之前,先使用工具箱的 “人声背景音分离” 功能,得到一个纯净的、只有小孩声音的音频(

vocal.wav)。 - 识别纯净人声:用这个

vocal.wav 文件进行语音识别(可以使用“工具箱 -> 批量语音转字幕”功能,或将其作为主界面的输入文件)。这样从根本上杜绝了狗叫的干扰。 - 后续合成:在最终视频合成时,再将识别翻译后生成的新配音,与分离出的背景音(含狗叫)合并,从而保留狗叫声。

总结建议:对于您的情况,优先尝试 第一步(降噪)和第二步(调高VAD阈值),这能解决大部分问题。如果狗叫声异常顽固,再采用备选方案中的人声分离。

相关文档链接:

调节VAD更精确控制语音识别结果

人声背景音分离