语音识别阶段出错 [faster-whisper(本地)] 7575.mp4没有识别出字幕,请检查是否包含人类说话声音,以及说话语言是否和你选择的原始语言匹配

Traceback (most recent call last):

File "videotrans\task\job.py", line 113, in run

File "videotrans\task\_speech2text.py", line 161, in recogn

RuntimeError: 7575.mp4没有识别出字幕,请检查是否包含人类说话声音,以及说话语言是否和你选择的原始语言匹配

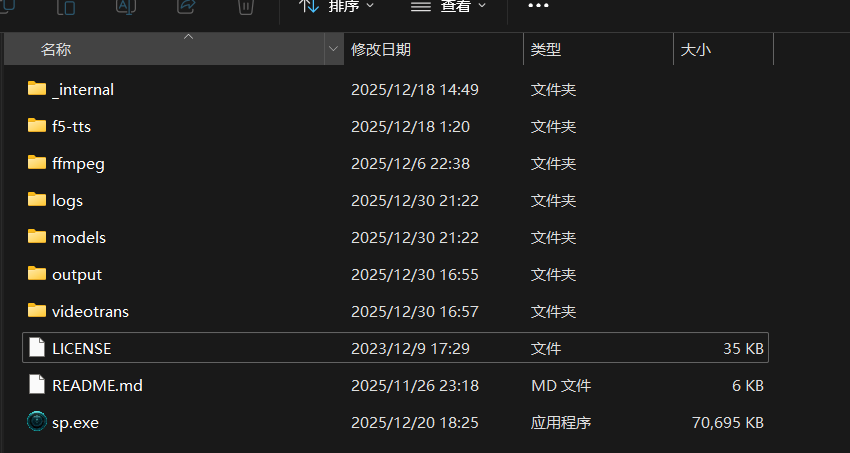

TaskCfg(cache_folder='D:/win-pyvideotrans-v3.91_20251220_225815/tmp/21584/45b8ec5d6e', target_dir='D:/win-pyvideotrans-v3.91_20251220_225815/output/recogn', remove_noise=False, is_separate=False, detect_language='auto', subtitle_language=None, source_language=None, target_language=None, source_language_code=None, target_language_code=None, source_sub=None, target_sub='D:/win-pyvideotrans-v3.91_20251220_225815/output/recogn/7575.srt', source_wav=None, source_wav_output=None, target_wav=None, target_wav_output=None, subtitles=None, novoice_mp4=None, noextname='7575', shibie_audio='D:/win-pyvideotrans-v3.91_20251220_225815/tmp/21584/45b8ec5d6e/7575-1767096849.5639434.wav', targetdir_mp4=None, instrument=None, vocal=None, back_audio=None, background_music=None, app_mode='biaozhun', subtitle_type=0, volume='+0%', pitch='+0Hz', voice_rate='+0%', voice_role=None, copysrt_rawvideo=False, clear_cache=False, translate_type=None, tts_type=None, recogn_type=0, model_name='large-v3-turbo', split_type=0, voice_autorate=False, video_autorate=False, cuda=True, name='C:/Users/Jackie/Videos/Captures/7575.mp4', basename='7575.mp4', ext='mp4', dirname='C:/Users/Jackie/Videos/Captures', shound_del_name=None, uuid='45b8ec5d6e', remove_silent_mid=False, align_sub_audio=True, enable_diariz=False, nums_diariz=0, rephrase=0, only_out_mp4=False)

=

system:Windows-10-10.0.22631-SP0

version:v3.91

frozen:True

language:zh

root_dir:D:/win-pyvideotrans-v3.91_20251220_225815