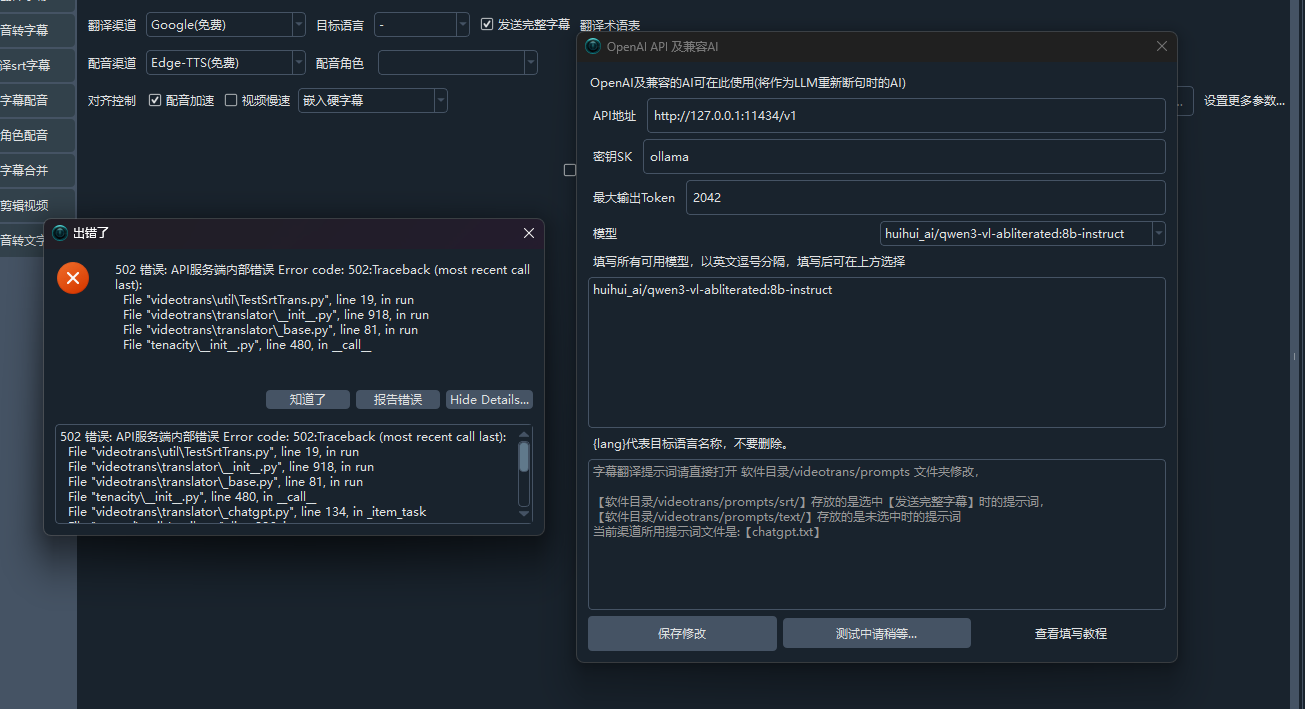

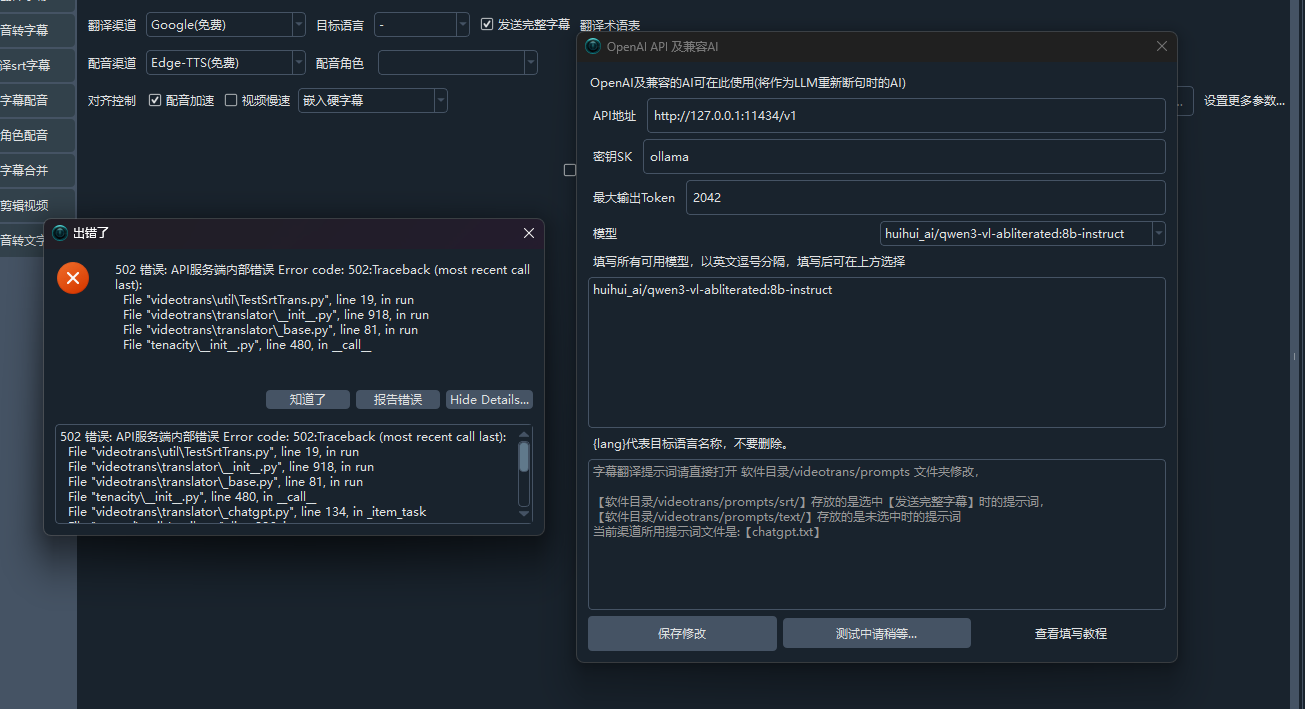

#2411 配置本地ollama测试时报错

188.253*

Posted at: 1 month ago 👁119

1 Replies

Post Your Reply

Open source and free maintenance is not easy. If this project is helpful to you, please consider making a small donation to help the project continue to maintain and update.