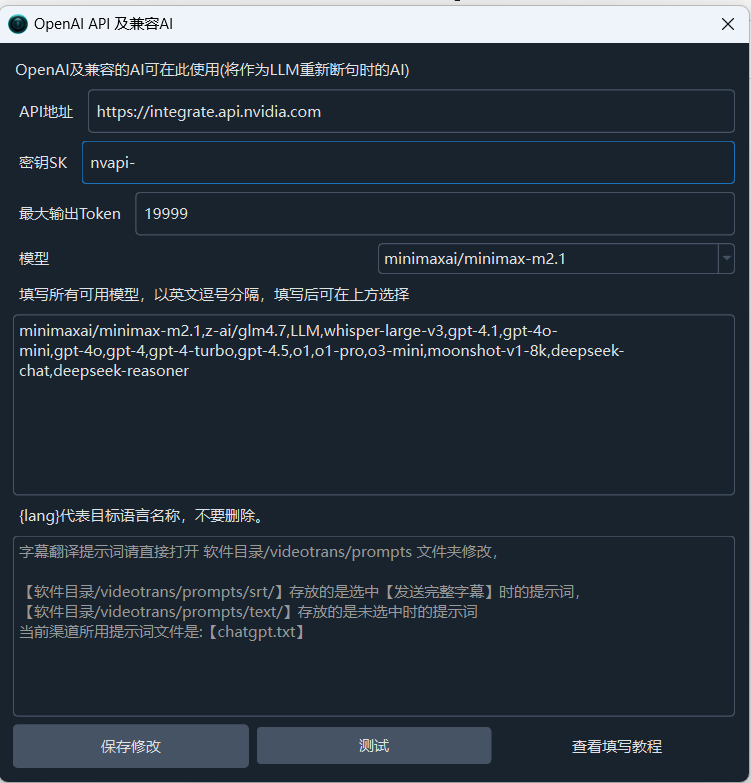

如何把NVIDIA的minimax-m2.1 和GLM-4.7加到翻译字幕中

#2829 如何把NVIDIA的minimax-m2.1 和GLM-4.7加到翻译字幕中

101.32*

Posted at: 1 month ago 👁119

11 Replies

Post Your Reply

Open source and free maintenance is not easy. If this project is helpful to you, please consider making a small donation to help the project continue to maintain and update.