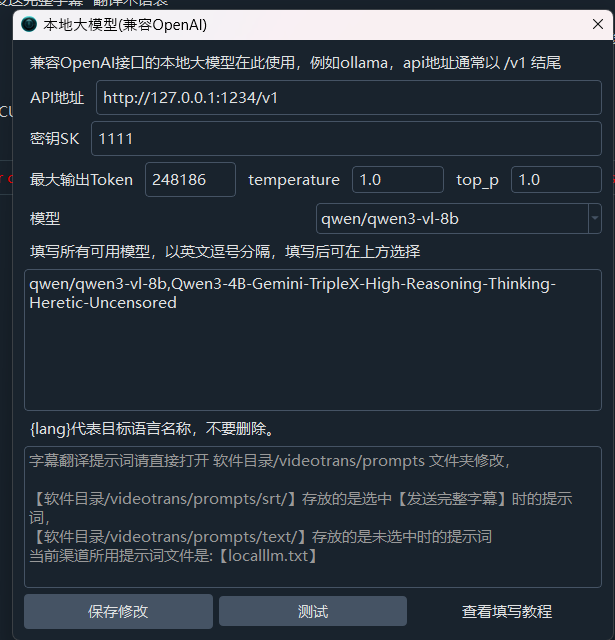

我已经在本地和这个软件里修改了token的长度为什么还是报错

#2877 我已经在本地和这个软件里修改了token的长度为什么还是报错

37.19*

Posted at: 1 month ago 👁102

1 Replies

Post Your Reply

Open source and free maintenance is not easy. If this project is helpful to you, please consider making a small donation to help the project continue to maintain and update.