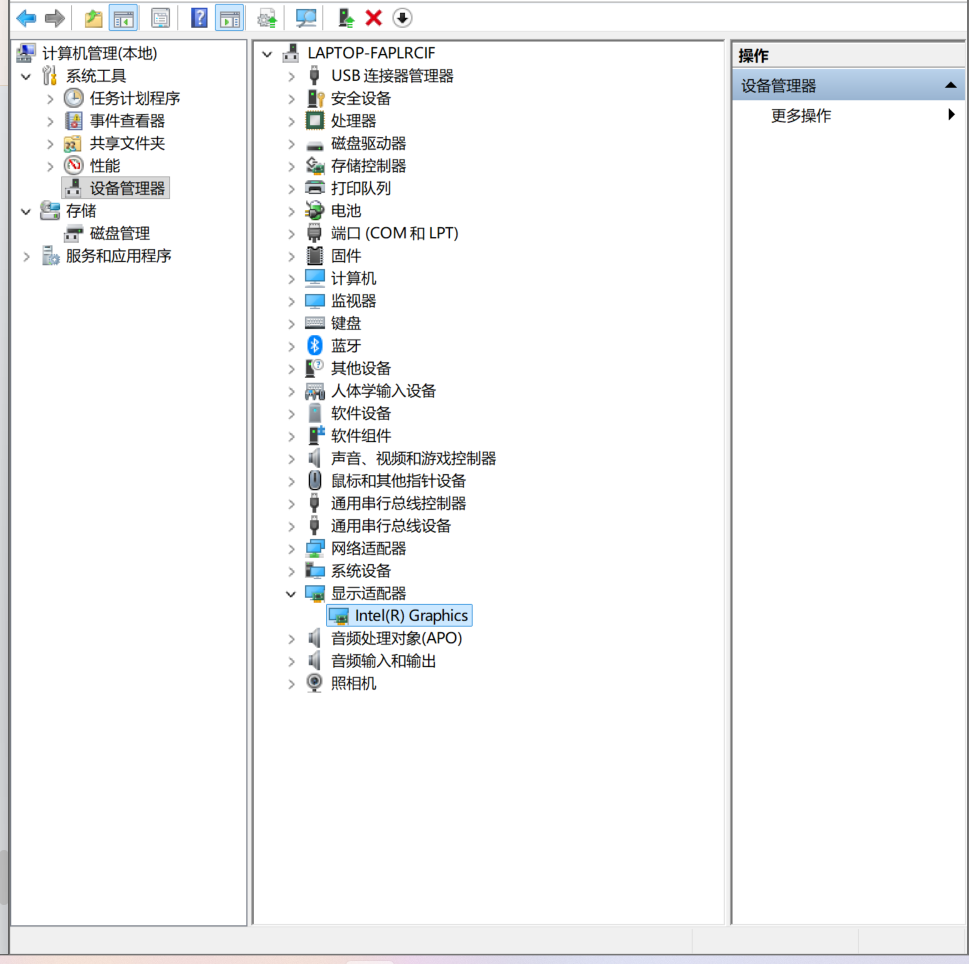

Traceback (most recent call last):

File "videotrans\util\checkgpu.py", line 14, in run

File "videotrans\util\gpus.py", line 21, in getset_gpu

AttributeError: module 'torch' has no attribute 'cuda'

=

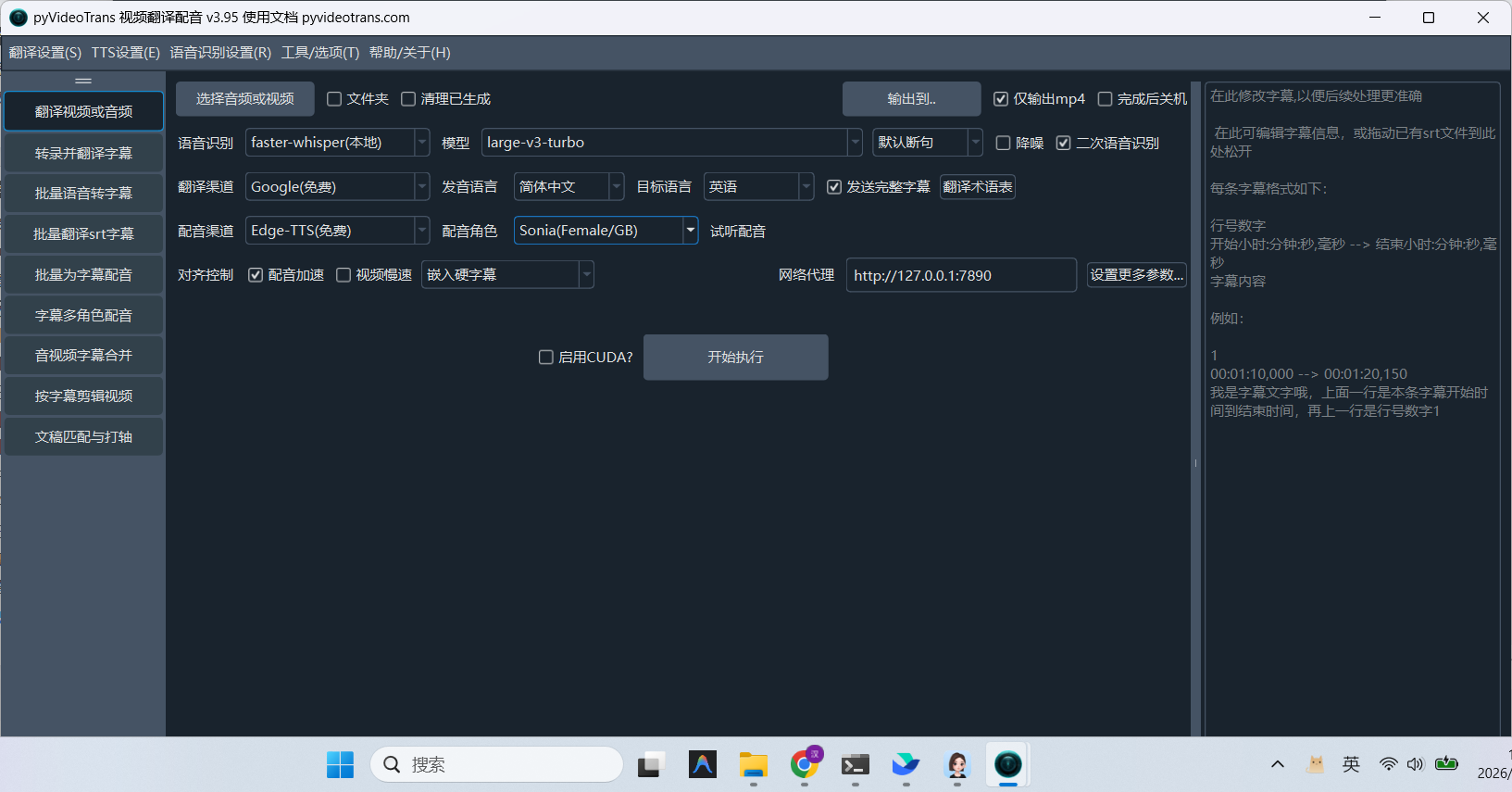

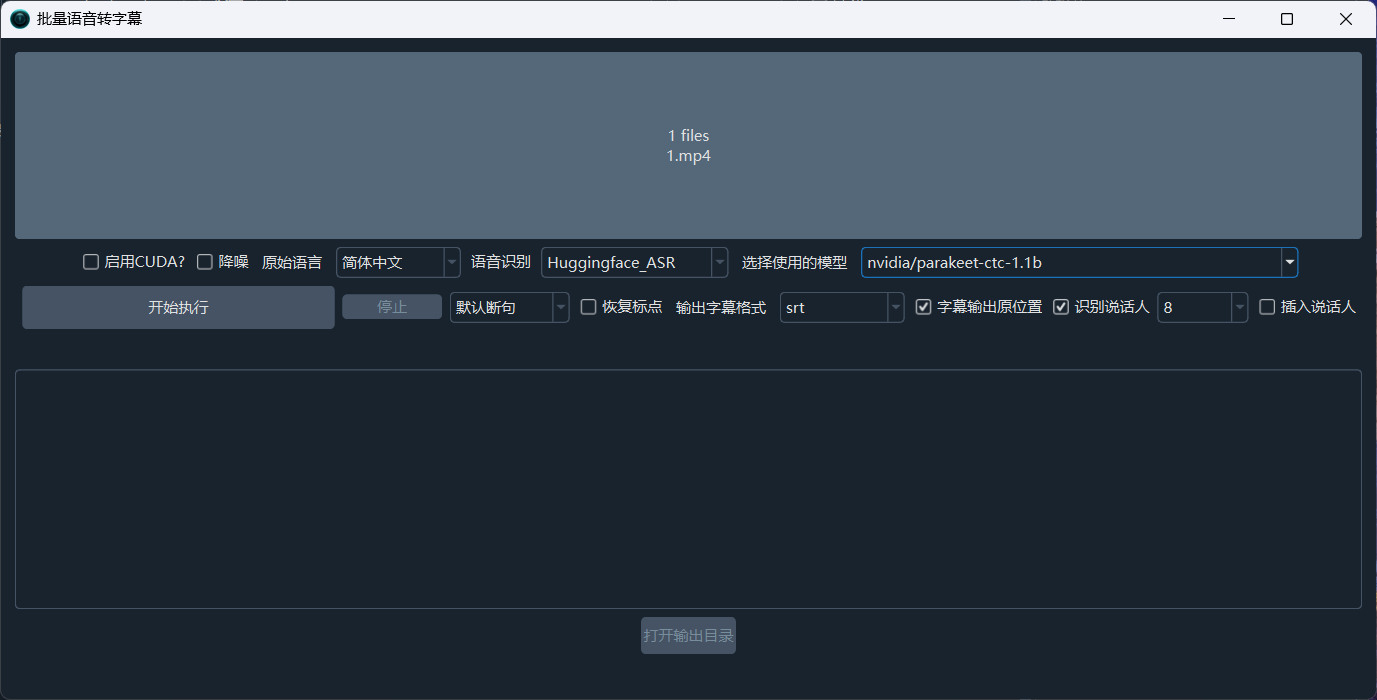

system:Windows-10-10.0.26200-SP0

version:v3.95

frozen:True

language:zh

root_dir:C:/Users/北笙/Downloads/win-pyvideotrans-v3.95