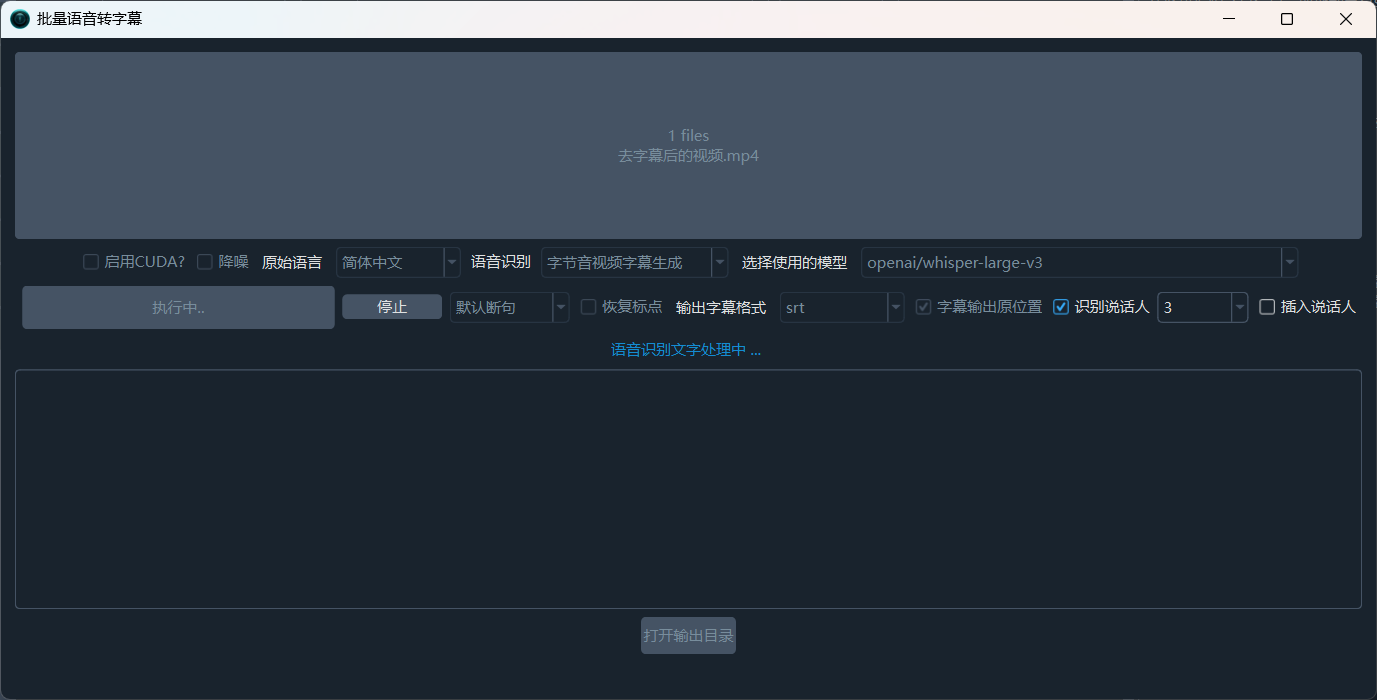

[ERROR] new process:concurrent.futures.process._RemoteTraceback:

"""

Traceback (most recent call last):

File "concurrent\futures\process.py", line 243, in _process_worker

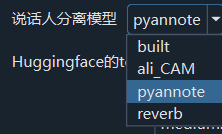

File "videotrans\process\prepare_audio.py", line 301, in pyannote_speakers

File "", line 1027, in _find_and_load

File "", line 1006, in _find_and_load_unlocked

File "", line 688, in _load_unlocked

File "pyimod02_importers.py", line 457, in exec_module

File "torch\__init__.py", line 270, in

_load_dll_libraries()

File "torch\__init__.py", line 253, in _load_dll_libraries

raise err

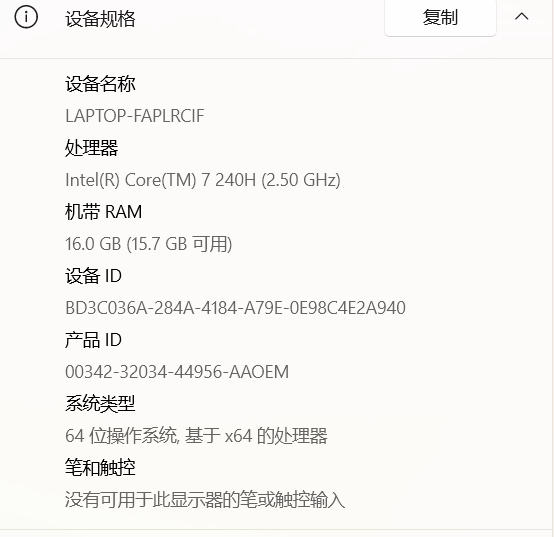

OSError: [WinError 193] %1 不是有效的 Win32 应用程序。 Error loading "C:\win-pyvideotrans-v3.95\_internal\torch\lib\shm.dll" or one of its dependencies.

"""

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "videotrans\configure\_base.py", line 272, in _new_process

File "concurrent\futures\_base.py", line 446, in result

File "concurrent\futures\_base.py", line 391, in __get_result

OSError: [WinError 193] %1 不是有效的 Win32 应用程序。

concurrent.futures.process._RemoteTraceback:

"""

我找到了,你看下这是什么原因呢