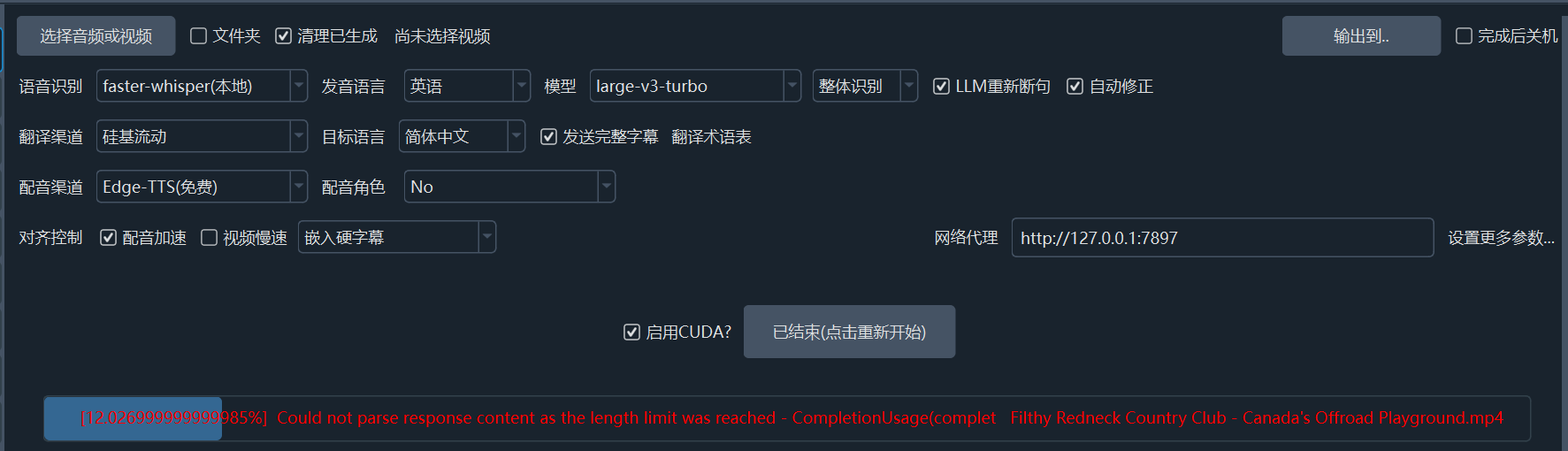

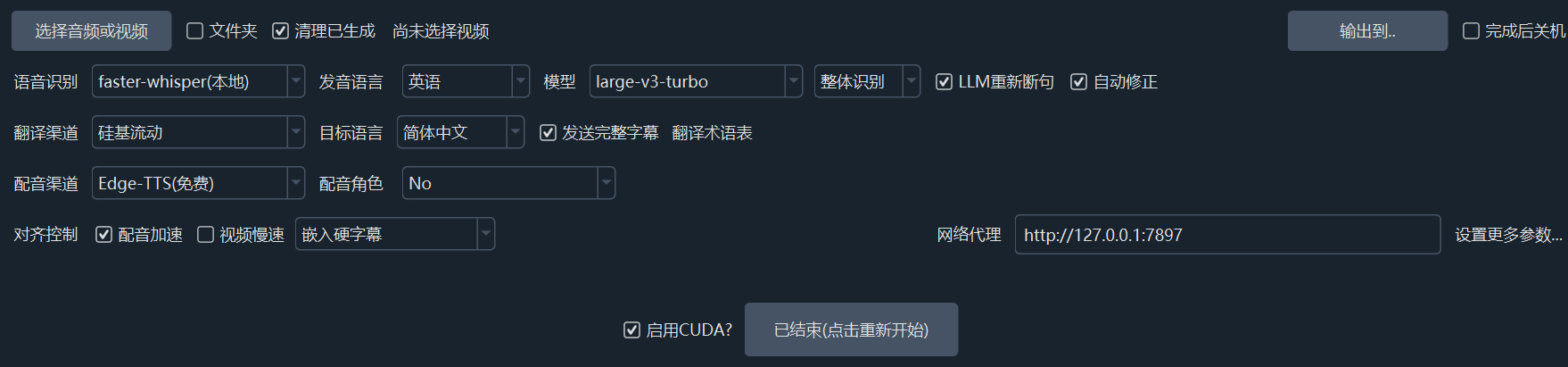

语音识别模型为 faster-whisper-large-v3;视频原始语言为英语,清理已生成也已勾选,如图:

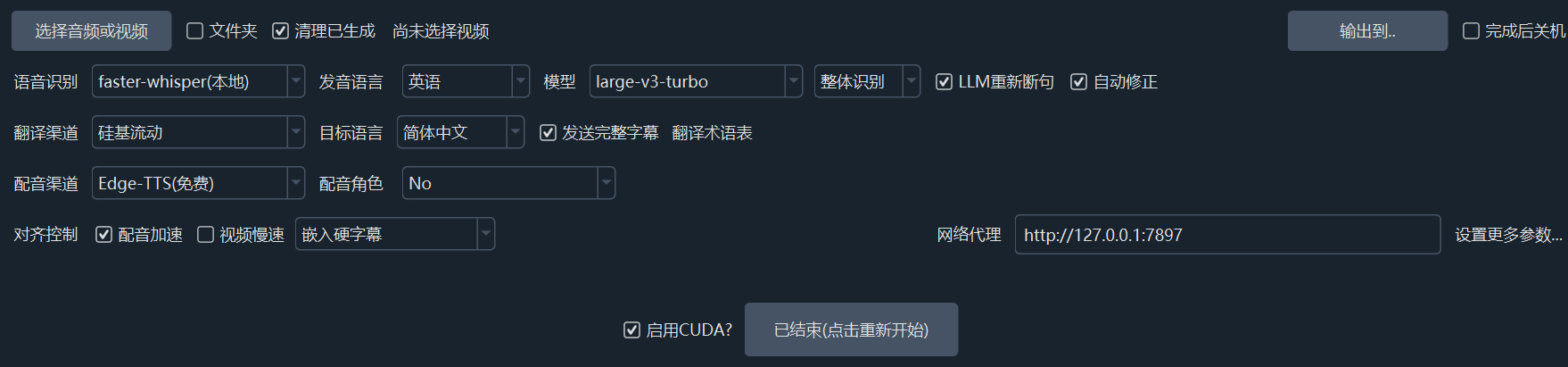

高级设置如下:

以下是错误日志:

The last spot', refusal=None, role='assistant', annotations=None, audio=None, function_call=None, tool_calls=None))], created=1764592833, model='deepseek-ai/DeepSeek-V3', object='chat.completion', service_tier=None, system_fingerprint='', usage=CompletionUsage(completion_tokens=4096, prompt_tokens=3698, total_tokens=7794, completion_tokens_details=None, prompt_tokens_details=None))

Traceback (most recent call last):

File "videotrans\task\_only_one.py", line 65, in run

File "videotrans\task\trans_create.py", line 423, in trans

File "videotrans\translator\__init__.py", line 925, in run

File "videotrans\translator\_base.py", line 77, in run

File "videotrans\translator\_base.py", line 135, in _run_srt

File "videotrans\translator\_siliconflow.py", line 64, in _item_task

openai.LengthFinishReasonError: Could not parse response content as the length limit was reached - CompletionUsage(completion_tokens=4096, prompt_tokens=3698, total_tokens=7794, completion_tokens_details=None, prompt_tokens_details=None)