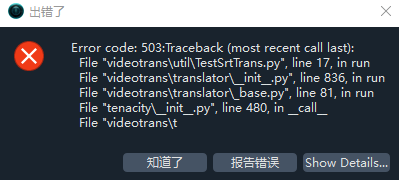

openai.InternalServerError: Error code: 503

Error code: 503:Traceback (most recent call last):

File "videotrans\util\TestSrtTrans.py", line 17, in run

File "videotrans\translator\__init__.py", line 836, in run

File "videotrans\translator\_base.py", line 81, in run

File "tenacity\__init__.py", line 480, in __call__

File "videotrans\translator\_localllm.py", line 63, in _item_task

File "openai\_utils\_utils.py", line 287, in wrapper

File "openai\resources\chat\completions\completions.py", line 1150, in create

File "openai\_base_client.py", line 1259, in post

File "openai\_base_client.py", line 1047, in request

openai.InternalServerError: Error code: 503

=====

Windows-10-10.0.19045-SP0

version:v3.80

frozen:True

language:zh

Ollama版本:0.12.3